Guida Definitiva al Test della Qualità della Traduzione AI

Punti Chiave:

- Perché è Importante: La qualità della traduzione influisce su fiducia, conformità e ricavi. Settori come quello medico (99,9% di precisione) e legale (98% di precisione) richiedono precisione.

-

Principali Obiettivi di Test:

- Precisione Semantica: Strumenti come COMET si allineano con le valutazioni umane nell'89% dei casi.

- Consistenza Terminologica: I settori legali richiedono il 99,5% di coerenza terminologica.

- Adattamento Culturale: Contenuti su misura possono aumentare la fidelizzazione degli utenti del 34%.

-

Metriche e Strumenti:

- Tradizionale: BLEU, TER, ROUGE (ad esempio, BLEU ≥0.4 per usabilità).

- Avanzato: COMET (0.81 di correlazione con i punteggi umani) e MQM per una dettagliata categorizzazione degli errori.

-

Sfide:

- Errori contestuali, lingue a bassa risorsa e dati di addestramento obsoleti.

- Esempio: Aggiungendo dati sui social media, l'accuratezza della traduzione curda è migliorata del 45%.

-

Soluzioni:

- I sistemi di apprendimento attivo riducono gli errori segnalando output a bassa fiducia.

- Combinare strumenti AI con il controllo umano migliora i tassi di rilevamento dei difetti al 91%.

Rapido Confronto delle Metriche:

| Metrica | Area di Focus | Uso & Soglia |

|---|---|---|

| BLEU | Precisione N-gram | Controlli rapidi, punteggi ≥0.4 |

| TER | Distanza di modifica | Grado professionale, <9% pref |

| ROUGE | Misura di richiamo | Validazione del contenuto, 0.3-0.5 |

| COMET | Valutazione semantica | Forte correlazione (0.81) |

| MQM | Categorizzazione degli errori | Dettaglio a livello aziendale |

Questa guida spiega come le aziende possano combinare l'automazione con l'esperienza umana per ottenere traduzioni scalabili, accurate e culturalmente rilevanti.

Metriche di Misurazione della Qualità

Gli strumenti moderni combinano automazione ed esperienza umana per fornire traduzioni precise e consapevoli del contesto. Queste metriche sono progettate per soddisfare obiettivi chiave come la precisione semantica, la coerenza terminologica e l'adattamento alle sfumature culturali.

Metriche di Base: BLEU, TER, ROUGE

Tre metriche fondamentali costituiscono la spina dorsale del test della qualità della traduzione:

| Metrica | Area di Focus | Uso & Soglia |

|---|---|---|

| BLEU | Precisione N-gram | Controlli rapidi, punteggi ≥0.4 sono utilizzabili |

| TER | Distanza di modifica | Grado professionale, <9% preferito |

| ROUGE | Misura di richiamo | Validazione del contenuto, gamma 0.3-0.5 |

Le traduzioni che ottengono un punteggio superiore a 0.6 su BLEU spesso superano la qualità media umana. Tuttavia, uno studio del 2023 ha evidenziato i limiti di BLEU: il BLEU a riferimento singolo aveva una debole correlazione con i giudizi umani (r=0.32), mentre le configurazioni a riferimenti multipli hanno funzionato meglio (r=0.68).

Nuove Metriche: COMET e MQM

I framework più recenti colmano le lacune nelle metriche tradizionali. COMET, alimentato da reti neurali, valuta la semantica e ha raggiunto una forte correlazione di 0.81 con i punteggi umani nei benchmark WMT2022 - molto migliore della correlazione di 0.45 di BLEU.

MQM suddivide gli errori in categorie come accuratezza, fluidità e terminologia, assegnando pesi di gravità. Questo approccio dettagliato è particolarmente utile per le traduzioni a livello aziendale.

Test Macchina vs. Umano

Un approccio equilibrato che combina valutazione macchina e umana è essenziale. I leader del settore hanno adottato flussi di lavoro come questo:

"Filtraggio iniziale TER → valutazione semantica COMET → post-editing umano per punteggi COMET <0.8 → revisione finale del cliente. Questo processo riduce i costi di valutazione del 40% mantenendo una conformità di qualità del 98%."

Per contenuti altamente specializzati, il coinvolgimento umano è indispensabile. Le metriche emergenti ora si concentrano su fattori come la coerenza contestuale e la cattura del tono emotivo, aprendo la strada per affrontare sfide pratiche. Questi progressi saranno discussi ulteriormente nella prossima sezione sui Problemi Comuni di Traduzione.

Problemi Comuni di Traduzione

Dati del settore evidenziano tre grandi sfide che spesso si presentano:

Contesto e Significato

Un significativo 38% delle traduzioni valutate con metriche BLEU di base necessita di intervento umano quando si tratta di espressioni idiomatiche. Questo problema è particolarmente pronunciato negli ambienti professionali.

"Una traduzione errata di un contratto UE di 'responsabilità solidale e congiunta' ha causato perdite per €2.8M, attribuite a dati di addestramento legali incompleti. L'analisi post-incidenti ha mostrato che l'aggiunta di 15mila documenti legali certificati ha ridotto errori simili del 78%"

Strumenti come l'analizzatore di contesto video di DubSmart hanno raggiunto un'accuratezza contestuale del 92% sincronizzando segnali visivi con dialoghi tradotti. Questo approccio ha ridotto notevolmente le traduzioni errate di genere del 63%, grazie all'uso del riconoscimento scena-oggetti.

Lingue Meno Comuni

Le lingue con meno risorse digitali affrontano ostacoli unici nella qualità della traduzione. Ecco una panoramica di come la disponibilità delle risorse impatta le prestazioni:

| Livello di Risorse | Impatto sulla Qualità | Efficacia della Soluzione |

|---|---|---|

| Lingue ad Alta Risorsa | Prestazioni di base | Test standard sufficienti |

| Lingue a Risorsa Media | Riduzione qualità del 15% | La retrotraduzione aiuta |

| Lingue a Bassa Risorsa | Punteggi TER più alti del 22% | Necessario apprendimento per trasferimento |

Uno studio sul caso della lingua curda evidenzia come l'aggiunta dei dati sui social media abbia migliorato l'accuratezza del 45%. Inoltre, l'apprendimento per trasferimento da famiglie linguistiche affini ha dimostrato di ridurre del 30% i dati di addestramento richiesti.

Qualità dei Dati di Addestramento

La qualità dei dati di addestramento gioca un ruolo cruciale nell'accuratezza delle traduzioni, particolarmente nei campi specializzati. Uno studio del 2024 ha rilevato che il 68% degli errori nella traduzione medica derivava da un bias verso la terminologia medica occidentale nei dataset di addestramento. Questo squilibrio è netto, con un rapporto di 5:1 a favore dei termini occidentali rispetto ai concetti di medicina tradizionale.

Anche le traduzioni tecniche incontrano sfide legate ai dati obsoleti:

"I glossari tecnici più vecchi di 3 anni mostrano tassi di errore più alti del 22%. Un progetto di traduzione di un manuale sui semiconduttori ha richiesto aggiornamenti mensili per mantenere <2% di errori terminologici"

I sistemi di apprendimento attivo che segnalano termini obsoleti si sono dimostrati efficaci, riducendo i carichi di revisione del 37%, specialmente nei domini tecnici.

Queste sfide sottolineano l'importanza dei metodi di test pratici coperti nella sezione successiva per garantire che la qualità della traduzione rimanga alta.

Testing nella Pratica

I metodi di test pratici affrontano le sfide dei dati di addestramento e del contesto attraverso alcune strategie mirate:

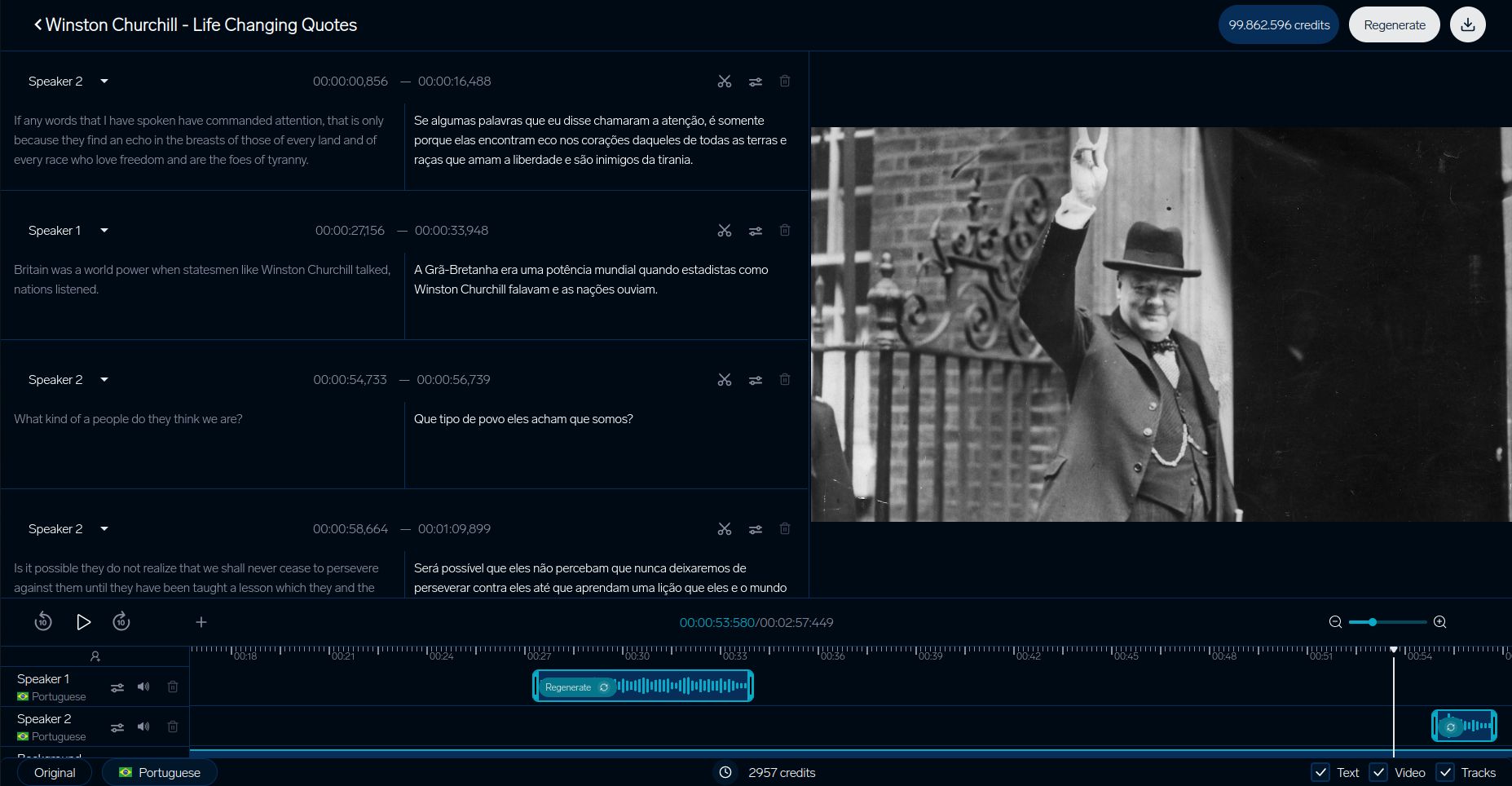

DubSmart Traduzione Video

Il sistema di test di DubSmart evidenzia come le piattaforme di traduzione video assicurano la qualità. Il loro processo dettagliato si concentra sull'allineamento del contesto visivo, affrontando in particolare i problemi di traduzione errata di genere discussi in precedenza:

| Componente | Metrica |

|---|---|

| Sincro Labiale | Ritardo inferiore a 200ms |

| Corrispondenza Vocale | Somiglianza 93% |

| Sincronizzazione Visiva | Meno del 5% di disallineamento |

Studi di Caso Aziendali

Grandi aziende hanno creato avanzati sistemi di test che combinano strumenti AI con l'esperienza umana. L'uso del framework MQM-DQF da parte di SAP è un esempio eccezionale:

"Combinando l'output MT neurale con i team di validazione linguistica, SAP ha ottenuto una riduzione del 40% dello sforzo di post-editing mantenendo tassi di precisione del 98%".

IKEA ha ottimizzato il suo processo di localizzazione del catalogo, riducendo il time-to-market del 35% attraverso una miscela di validazione umana e AI.

Anche Booking.com dimostra la potenza del test automatizzato. Il loro sistema gestisce oltre 1 miliardo di traduzioni ogni anno in 45 lingue, riducendo i costi del 40% mantenendo la qualità costante per i contenuti generati dagli utenti.

Questi esempi evidenziano come le aziende stiano migliorando accuratezza, efficienza e scalabilità nel test delle traduzioni.

sbb-itb-f4517a0

Prossimi Passi nei Test di Traduzione

Con il miglioramento dei metodi di test, tre aree chiave stanno spingendo gli standard di qualità a nuovi livelli:

Trasferimento del Tono e delle Emozioni

I sistemi moderni sono ora migliori nel preservare le sfumature emotive, grazie al framework EMO-BLEU, che ha una correlazione di Pearson di 0.73 con la percezione umana rispetto a quella di 0.41 di BLEU. I modelli di trasformatori multimodali hanno fatto significativi progressi, mantenendo intatte le emozioni del parlante. Questi sistemi possono mantenere variazioni di intensità entro ±2dB tra le lingue mentre gestiscono marcatori emotivi complessi.

Traduzione Basata sul Contesto

I sistemi consapevoli del contesto stanno ridisegnando il modo in cui si valuta la qualità della traduzione. Un ottimo esempio è la Modalità Contesto di DeepL, che utilizza il tracciamento docum mentale degli enti e regolazioni di formalità in tempo reale.

Test per questi sistemi sono diventati più avanzati, focalizzandosi su importanti benchmark:

| Componente del Test | Benchmark Corrente | Focus di Misurazione |

|---|---|---|

| Risposta alla Prima Parola | <900ms | Accuratezza dell'inizio del discorso |

| Qualità dello Streaming | <4 parole di lag | Coerenza del buffer |

| Allineamento Contestuale | >0.8 punteggio | Adattamento dinamico |

Questi sistemi gestiscono oltre 100 milioni di coppie di frasi contestuali, complete di annotazioni stratificate.

Sistemi AI di Apprendimento

I sistemi di traduzione che si migliorano autonomamente stanno cambiando il modo in cui si testa la qualità integrando un feedback continuo. Il framework di Orq.ai evidenzia questo cambiamento, riducendo i costi di post-editing del 37% trimestralmente attraverso:

"Architetture di apprendimento attivo che segnalano segmenti a bassa fiducia con punteggi COMET sotto 0.6, presentando alternative tramite UI della tipologia di errore MQM e aggiornando i pesi del modello ogni due settimane usando campioni validati".

Questi sistemi identificano automaticamente le traduzioni a bassa fiducia (COMET <0.6) e aggiornano i loro modelli ogni due settimane usando campioni validati da linguisti. Tuttavia, devono anche affrontare sfide etiche. La ricerca del MIT mostra una deriva del 22% nella neutralità di genere senza misure di debiasing adeguate. Questo problema è legato a problemi con dati di addestramento distorti, sottolineando la necessità di protocolli di monitoraggio aggiornati.

Strumenti del settore come TAUS Dynamic Quality Framework v3.1 aiutano a garantire che questi sistemi soddisfino standard in evoluzione.

Sommario

Metodi di Testing Chiave

Le tecniche moderne di test si sono evolute oltre il semplice confronto n-gram e ora si concentrano sull'analisi contestuale. Le metriche tradizionali come BLEU, TER e ROUGE forniscono ancora una base per le valutazioni di base. Tuttavia, metodi più recenti come COMET e MQM si sono dimostrati più allineati con il giudizio umano.

Ad esempio, il framework EMO-BLEU ha dimostrato che le metriche automatizzate possono raggiungere una correlazione del 73% con il giudizio umano quando si valuta quanto bene viene conservato il contenuto emotivo. Oggi, il test di qualità sottolinea non solo l'accuratezza tecnica, ma anche l'importanza di allinearsi con le sfumature culturali, un obiettivo chiave per le implementazioni a livello aziendale.

Strumenti e Risorse

Il test moderno della traduzione utilizza spesso piattaforme che uniscono diversi metodi di valutazione. Un esempio è DubSmart, che offre una vasta gamma di funzionalità di test e sistemi avanzati di verifica dei contenuti.

Componenti chiave di un test efficace includono:

- Gates di qualità basati su COMET con soglie inferiori a 0.6

- Glossari che sono stati rivisti per la rilevanza culturale

- Sistemi di apprendimento attivo aggiornati ogni due settimane

Per campi specializzati come quello medico, legale e tecnico, il test combina metriche generali con quelle specifiche del settore. Questo approccio ha portato a un miglioramento del 22% nella qualità quando si utilizzano sistemi di valutazione combinati.

FAQ

Quali sono gli svantaggi del punteggio BLEU?

Il punteggio BLEU, sebbene ampiamente utilizzato, presenta limitazioni notevoli quando applicato alla valutazione della qualità della traduzione. Ecco i suoi principali punti deboli:

| Limitazione | Effetto sulla Valutazione della Traduzione |

|---|---|

| Cecità Semantica | Si concentra solo sulle corrispondenze delle parole, ignorando il significato o il contesto |

| Sanzioni per la Diversità della Frase | Penalizza traduzioni valide che usano una fraseologia diversa dai testi di riferimento |

Per affrontare questi problemi, molte piattaforme di localizzazione video utilizzano una combinazione di metodi di valutazione. Ad esempio, l'analizzatore contestuale di DubSmart combina più metriche per fornire una valutazione più accurata.

"Sebbene BLEU fornisca misurazioni di base, il test completo richiede analisi semantiche e contestuali - soprattutto per traduzioni critiche per il business."

Per una maggiore accuratezza, gli esperti suggeriscono:

- COMET per valutare il significato e la semantica

- Validazione umana per comprendere le sfumature culturali

- Strumenti specifici per lingua per gestire strutture grammaticali complesse

Questo approccio stratificato, come utilizzato da DubSmart, combina strumenti automatizzati con intuizioni umane per garantire che le traduzioni soddisfino sia gli standard tecnici che quelli contestuali.