Ultimativer Leitfaden zur Qualitätsprüfung von KI-Übersetzungen

Wichtige Erkenntnisse:

- Warum es wichtig ist: Die Übersetzungsqualität beeinflusst Vertrauen, Compliance und Einnahmen. Branchen wie die Medizin (99,9% Genauigkeit) und das Rechtswesen (98% Genauigkeit) erfordern Präzision.

-

Hauptziele der Prüfung:

- Semantische Genauigkeit: Tools wie COMET stimmen zu 89% mit menschlichen Bewertungen überein.

- Terminologiekonsistenz: Rechtliche Bereiche verlangen 99,5% Terminkonsistenz.

- Kulturelle Anpassung: Maßgeschneiderte Inhalte können die Benutzerbindung um 34% erhöhen.

-

Metriken & Tools:

- Traditionell: BLEU, TER, ROUGE (z. B. BLEU ≥0,4 für Nutzbarkeit).

- Erweitert: COMET (0,81 Korrelation mit menschlichen Bewertungen) und MQM für detaillierte Fehlerkategorisierung.

-

Herausforderungen:

- Kontextuelle Fehler, ressourcenarme Sprachen und veraltete Trainingsdaten.

- Beispiel: Das Hinzufügen von Social-Media-Daten verbesserte die Übersetzungsgenauigkeit für Kurdisch um 45%.

-

Lösungen:

- Aktive Lernsysteme reduzieren Fehler, indem sie Ausgaben mit geringem Vertrauen kennzeichnen.

- Die Kombination von KI-Tools mit menschlicher Überwachung verbessert die Erkennungsrate von Mängeln auf 91%.

Schneller Vergleich von Metriken:

| Metrik | Fokusbereich | Anwendungsfall & Schwelle |

|---|---|---|

| BLEU | N-Gramm-Präzision | Schnelle Überprüfungen, Scores ≥0,4 |

| TER | Editierdistanz | Professionelle Qualität, <9% bevorzugt |

| ROUGE | Messung des Rückrufs | Inhaltsvalidierung, 0,3-0,5 |

| COMET | Semantische Bewertung | Starke Korrelation (0,81) |

| MQM | Fehlerkategorisierung | Detaillierung auf Unternehmensebene |

Dieser Leitfaden erklärt, wie Unternehmen Automatisierung und menschliche Expertise kombinieren können, um skalierbare, genaue und kulturell relevante Übersetzungen zu erreichen.

Qualitätsmessmetriken

Moderne Tools verbinden Automatisierung mit menschlicher Expertise, um genaue und kontextbewusste Übersetzungen zu liefern. Diese Metriken sind darauf ausgelegt, wichtige Ziele wie semantische Genauigkeit, Terminologiekonsistenz und Anpassung an kulturelle Nuancen zu erfüllen.

Grundlegende Metriken: BLEU, TER, ROUGE

Drei Kernmetriken bilden das Rückgrat der Übersetzungsqualitätsprüfung:

| Metrik | Fokusbereich | Anwendungsfall & Schwelle |

|---|---|---|

| BLEU | N-Gramm-Präzision | Schnelle Überprüfungen, Scores ≥0,4 sind nutzbar |

| TER | Editierdistanz | Professionelle Qualität, <9% bevorzugt |

| ROUGE | Messung des Rückrufs | Inhaltsvalidierung, 0,3-0,5 Bereich |

Übersetzungen, die auf der BLEU-Skala über 0,6 erreichen, übertreffen oft die durchschnittliche menschliche Qualität. Eine Studie aus dem Jahr 2023 hob jedoch die Einschränkungen von BLEU hervor: Das Einzelreferenz-BLEU zeigte eine schwache Korrelation mit menschlichen Urteilen (r=0,32), während Mehrfachreferenz-Setups besser abschnitten (r=0,68).

Neue Metriken: COMET und MQM

Neuere Frameworks adressieren Lücken in traditionellen Metriken. COMET, betrieben durch neuronale Netzwerke, bewertet Semantik und erzielte eine starke 0,81-Korrelation mit menschlichen Bewertungen in den WMT2022 Benchmarks - weit besser als BLEUs 0,45-Korrelation.

MQM unterteilt Fehler in Kategorien wie Genauigkeit, Flüssigkeit und Terminologie und weist Schweregewichte zu. Dieser detaillierte Ansatz eignet sich besonders für unternehmensgerechte Übersetzungen.

Maschinelles vs. menschliches Testen

Ein ausgewogener Ansatz, der maschinelle und menschliche Bewertungen kombiniert, ist unerlässlich. Branchenführer haben Arbeitsabläufe wie diesen übernommen:

"Anfängliche TER-Filterung → COMET-semantic Evaluation → menschliche Nachbearbeitung für COMET-Scores <0,8 → abschließende Kundenbewertung. Dieser Prozess reduziert Evaluierungskosten um 40%, während er eine Qualitätskonformität von 98% aufrechterhält."

Für hochspezialisierte Inhalte ist menschliches Engagement unerlässlich. Neue Metriken konzentrieren sich jetzt auf Faktoren wie kontextuelle Konsistenz und das Erfassen des emotionalen Tons, die den Weg ebnen, um praktische Herausforderungen anzugehen. Diese Fortschritte werden im nächsten Abschnitt über häufige Übersetzungsprobleme weiter erörtert.

Häufige Übersetzungsprobleme

Branchendaten weisen auf drei große Herausforderungen hin, die häufig auftreten:

Kontext und Bedeutung

Ein bedeutender Teil von 38% der mit grundlegenden BLEU-Metriken bewerteten Übersetzungen erfordert menschliches Eingreifen, wenn es um idiomatische Ausdrücke geht. Dieses Problem ist besonders in professionellen Umfeldern ausgeprägt.

"Eine Fehlübersetzung eines EU-Vertrags von 'gemeinsam und solidarisch haftbar' führte zu Verlusten in Höhe von 2,8 Mio. €, die durch unvollständige rechtliche Trainingsdaten zurückzuführen waren. Die Nachanalyse ergab, dass das Hinzufügen von 15.000 zertifizierten Rechtsdokumenten ähnliche Fehler um 78% reduzierte"

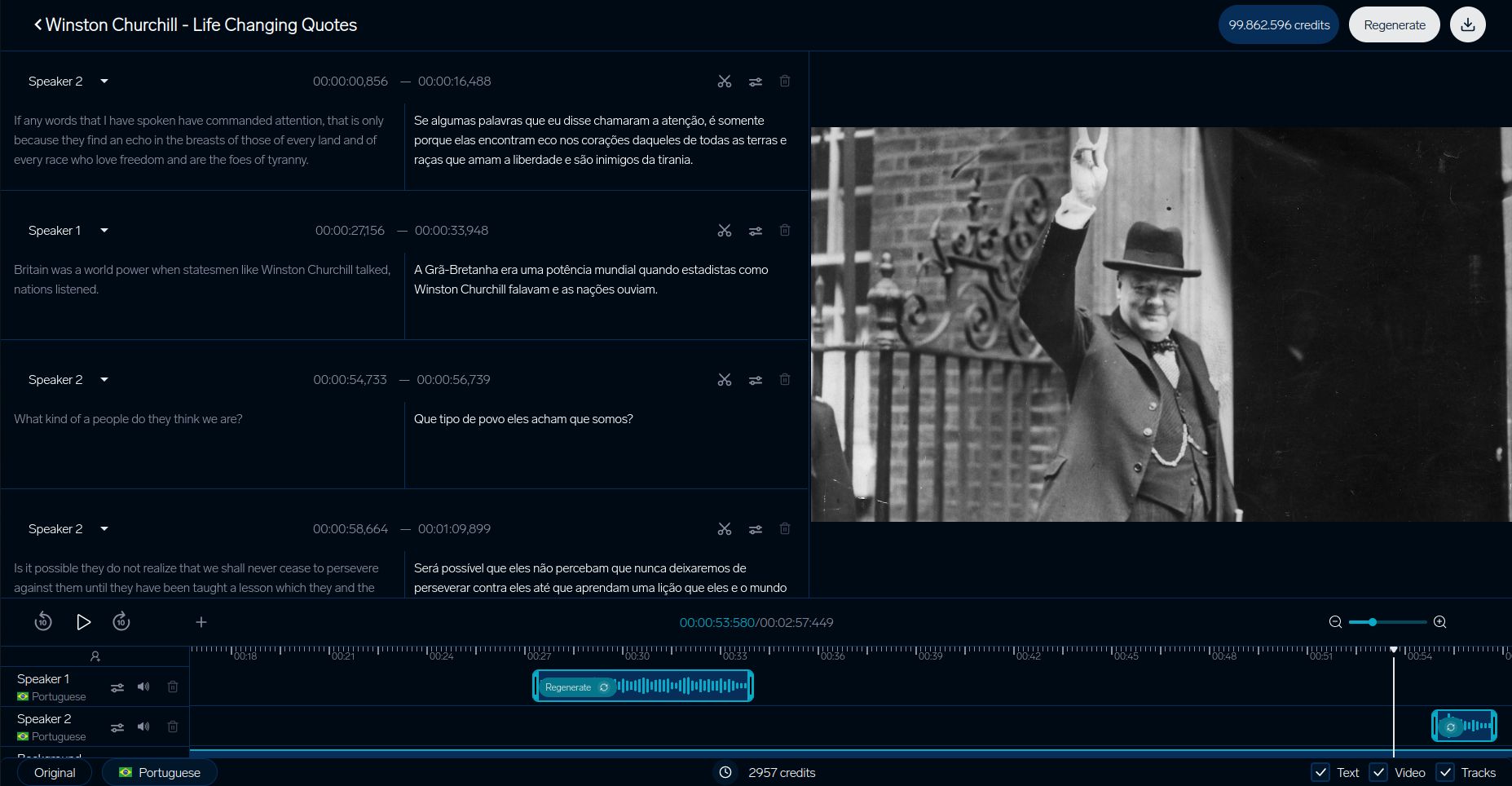

Tools wie DubSmarts Video-Kontextanalysator haben eine kontextuelle Genauigkeit von 92% erreicht, indem visuelle Hinweise mit übersetztem Dialog synchronisiert werden. Dieser Ansatz hat insbesondere die Anzahl der Geschlechtsfehlübersetzungen um 63% reduziert, dank der Nutzung von Szene-Objekt-Erkennung.

Weniger verbreitete Sprachen

Sprachen mit weniger digitalen Ressourcen stehen vor einzigartigen Hürden in der Übersetzungsqualität. Hier ist eine Übersicht darüber, wie sich die Verfügbarkeit von Ressourcen auf die Leistung auswirkt:

| Ressourcenniveau | Auswirkung auf die Qualität | Effektivität der Lösung |

|---|---|---|

| Sprachen mit hohem Ressourcenbestand | Basisleistung | Standardprüfungen ausreichend |

| Sprachen mit mittlerem Ressourcenbestand | 15% Qualitätsminderung | Rückwärtsübersetzung hilft |

| Sprachen mit geringem Ressourcenbestand | 22% höhere TER-Scores | Transferlernen benötigt |

Eine Fallstudie zur kurdischen Sprache zeigt, wie das Hinzufügen von Social-Media-Daten die Genauigkeit um 45% verbesserte. Darüber hinaus hat das Transferlernen von verwandten Sprachfamilien den benötigten Trainingsdatenbedarf um 30% reduziert.

Qualität der Trainingsdaten

Die Qualität der Trainingsdaten spielt eine entscheidende Rolle für die Übersetzungsgenauigkeit, insbesondere in spezialisierten Bereichen. Eine Studie aus dem Jahr 2024 ergab, dass 68% der medizinischen Übersetzungsfehler auf eine Voreingenommenheit gegenüber westlicher medizinischer Terminologie in den Trainingsdatensätzen zurückzuführen waren. Dieses Ungleichgewicht ist auffällig, mit einem Verhältnis von 5:1 zugunsten westlicher Begriffe gegenüber traditionellen medizinischen Konzepten.

Technische Übersetzungen stoßen ebenfalls auf Herausforderungen im Zusammenhang mit veralteten Daten:

"Technische Glossare, die älter als 3 Jahre sind, zeigen 22% höhere Fehlerraten. Ein Halbleiterhandbuch-Übersetzungsprojekt erforderte monatliche Updates, um <2% Begrifffehler aufrechtzuerhalten"

Aktive Lernsysteme, die veraltete Begriffe kenntlichen, haben sich als effektiv erwiesen und die Arbeitsbelastung durch Überarbeitungen um 37% reduziert, insbesondere in technischen Bereichen.

Diese Herausforderungen unterstreichen die Bedeutung der im nächsten Abschnitt behandelten praktischen Testmethoden, um sicherzustellen, dass die Übersetzungsqualität hoch bleibt.

Testen in der Praxis

Praktische Testmethoden adressieren die Herausforderungen von Trainingsdaten und Kontext durch einige fokussierte Strategien:

DubSmart Videoübersetzung

DubSmarts Testsistem hebt hervor, wie Videoübersetzungsplattformen Qualität sicherstellen. Ihr detaillierter Prozess konzentriert sich auf die Abstimmung auf den visuellen Kontext, insbesondere bei der Bewältigung von Geschlechtsfehlübersetzungsproblemen, die zuvor angesprochen wurden:

| Komponente | Metrik |

|---|---|

| Lip-Synchron | Weniger als 200 ms Verzögerung |

| Stimmenabgleich | 93% Ähnlichkeit |

| Visuelle Synchronisierung | Weniger als 5% Fehlanpassung |

Business Case-Studien

Große Unternehmen haben erweiterte Testsysteme entwickelt, die KI-Tools mit menschlicher Expertise kombinieren. Die Nutzung des MQM-DQF-Frameworks durch SAP ist ein herausragendes Beispiel:

"Durch die Kombination der Ausgaben von neuronaler MT mit Validierungsteams von Linguisten erreichte SAP eine Reduzierung des Nachbearbeitungsaufwands um 40%, während 98% Genauigkeitsraten aufrechterhalten wurden".

IKEA hat seinen Kataloglokaliserungsprozess optimiert und die Markteinführungszeit durch eine Mischung aus menschlicher und KI-Validierung um 35% verkürzt.

Booking.com zeigt auch die Kraft der automatisierten Tests. Ihr System verarbeitet über 1 Milliarde Übersetzungen jährlich in 45 Sprachen und senkt die Kosten um 40%, während die Qualität für nutzergenerierte Inhalte konsistent bleibt.

Diese Beispiele zeigen, wie Unternehmen Genauigkeit, Effizienz und Skalierbarkeit bei Übersetzungstests verbessern.

sbb-itb-f4517a0

Nächste Schritte beim Übersetzungstest

Da sich die Testmethoden verbessern, treiben drei Schlüsselfelder die Qualitätsstandards auf neue Höhen:

Ton- und Emotionstransfer

Moderne Systeme sind jetzt besser darin, emotionale Nuancen zu bewahren, dank des EMO-BLEU-Frameworks, das eine 0,73-Pearson-Korrelation mit menschlicher Wahrnehmung aufweist, verglichen mit BLEUs 0,41. Multimodale Transformator-Modelle haben sich erheblich weiterentwickelt, um die Emotionen des Sprechers intakt zu halten. Diese Systeme können Intensitätsvariationen innerhalb von ±2 dB über Sprachen hinweg aufrechterhalten und komplexe emotionale Marker verwalten.

Kontextbasierte Übersetzung

Kontextbewusste Systeme verändern, wie Übersetzungsqualität bewertet wird. Ein hervorragendes Beispiel ist der Kontextmodus von DeepL, der dokumentenbasiertes Entitäts-Tracking und Echtzeit-Formalanpassungen verwendet.

Tests für diese Systeme sind fortschrittlicher geworden und konzentrieren sich auf wichtige Benchmarks:

| Testkomponente | Aktueller Benchmark | Messfokus |

|---|---|---|

| Erstes-Wort-Antwort | <900 ms | Genauigkeit des Sprachbeginns |

| Streamqualität | <4-Wort Verzögerung | Puffer-Konsistenz |

| Kontextausrichtung | >0,8 Score | Dynamische Anpassung |

Diese Systeme bearbeiten über 100 Millionen kontextuelle Satzpaare, komplett mit geschichteten Anmerkungen.

Lernende KI-Systeme

Übersetzungssysteme, die sich selbst verbessern, verändern, wie Qualität getestet wird, indem sie kontinuierliches Feedback integrieren. Das Framework von Orq.ai hebt diesen Wandel hervor und senkt die Nachbearbeitungskosten vierteljährlich um 37% durch:

"Aktive Lernarchitekturen, die Segmente mit geringem Vertrauen mit COMET-Scores unter 0,6 kennzeichnen, bieten Alternativen über die MQM-Fehlertypologie-UI an und aktualisieren Modellgewichte zweiwöchentlich mit validierten Stichproben".

Diese Systeme identifizieren Low-Confidence-Übersetzungen (COMET <0,6) automatisch und aktualisieren ihre Modelle alle zwei Wochen mit von Linguisten validierten Stichproben. Sie stehen jedoch auch vor ethischen Herausforderungen. Forschung von MIT zeigt eine 22% Drift in der Geschlechtsneutralität ohne ordnungsgemäße Debiasing-Maßnahmen. Dieses Problem geht auf Probleme mit voreingenommenen Trainingsdaten zurück und unterstreicht die Notwendigkeit aktualisierter Überwachungsprotokolle.

Branchenwerkzeuge wie das TAUS Dynamic Quality Framework v3.1 helfen sicherzustellen, dass diese Systeme sich entwickelnden Standards gerecht werden.

Zusammenfassung

Wichtige Testmethoden

Moderne Testtechniken sind über das einfache N-Gramm-Matching hinausgewachsen und konzentrieren sich nun auf kontextuelle Analysen. Traditionelle Metriken wie BLEU, TER und ROUGE bieten weiterhin eine Grundlage für Basisevaluationen. Neuere Methoden wie COMET und MQM haben sich jedoch als stärker mit menschlichen Urteilen übereinstimmend erwiesen.

Zum Beispiel hat das EMO-BLEU-Framework gezeigt, dass automatisierte Metriken eine 73%ige Korrelation mit menschlichem Urteil erreichen können, wenn es darum geht, wie gut emotionaler Inhalt bewahrt wird. Heute betonen Qualitätstests nicht nur technische Genauigkeit, sondern auch die Bedeutung der Anpassung an kulturelle Nuancen, ein Schlüsselziel für Implementierungen auf Unternehmensebene.

Tools und Ressourcen

Moderne Übersetzungstests verwenden häufig Plattformen, die mehrere Bewertungsmethoden zusammenführen. Ein Beispiel ist DubSmart, das eine breite Palette von Testfunktionen und fortschrittlichen Inhaltsverifizierungssystemen bietet.

Wichtige Komponenten effektiver Tests umfassen:

- COMET-basierte Qualitätsgates mit Schwellenwerten unter 0,6

- Glossare, die auf kulturelle Relevanz überprüft wurden

- Alle zwei Wochen aktualisierte aktive Lernsysteme

Für spezialisierte Bereiche wie medizinische, rechtliche und technische Inhalte kombinieren Tests allgemeine Metriken mit branchenspezifischen. Dieser Ansatz führte zu einer 22%igen Verbesserung der Qualität bei der Verwendung von kombinierten Bewertungssystemen.

FAQs

Was sind die Nachteile des BLEU-Scores?

Der BLEU-Score ist zwar weit verbreitet, hat jedoch bemerkenswerte Einschränkungen, wenn es um die Bewertung der Übersetzungsqualität geht. Hier sind die Hauptschwächen:

| Einschränkung | Auswirkung auf die Übersetzungsbewertung |

|---|---|

| Semantische Blindheit | Konzentriert sich nur auf Wortmatches und ignoriert Bedeutung oder Kontext |

| Umformulierungsdiversitätsstrafen | Strafen für gültige Übersetzungen, die eine andere Formulierung als Referenztexte verwenden |

Um diese Probleme zu adressieren, verwenden viele Video-Lokalisierungsplattformen eine Mischung aus Bewertungsmethoden. Zum Beispiel kombiniert der Kontextanalysator von DubSmart mehrere Metriken, um eine genauere Bewertung zu liefern.

"Während BLEU Basiswerte liefert, erfordert eine umfassende Prüfung semantische und kontextuelle Analysen - insbesondere bei geschäftskritischen Übersetzungen."

Für eine bessere Genauigkeit empfehlen Experten:

- COMET zur Bewertung von Bedeutung und Semantik

- Menschliche Validierung zur Aufnahme kultureller Nuancen

- Sprachspezifische Tools zur Handhabung komplexer grammatikalischer Strukturen

Dieser mehrschichtige Ansatz, wie er von DubSmart verwendet wird, kombiniert automatisierte Tools mit menschlichen Einblicken, um sicherzustellen, dass Übersetzungen sowohl technische als auch kontextuelle Standards erfüllen.