Guía Definitiva para la Prueba de Calidad de Traducción de IA

Aspectos Clave:

- Por qué es Importante: La calidad de la traducción impacta en la confianza, el cumplimiento y los ingresos. Industrias como la médica (99.9% de precisión) y la legal (98% de precisión) requieren precisión.

-

Objetivos Principales de la Prueba:

- Precisión Semántica: Herramientas como COMET se alinean con las calificaciones humanas el 89% del tiempo.

- Consistencia Terminológica: Los campos legales exigen un 99.5% de consistencia en términos.

- Adaptación Cultural: El contenido personalizado puede aumentar la retención de usuarios en un 34%.

-

Métricas y Herramientas:

- Tradicional: BLEU, TER, ROUGE (por ejemplo, BLEU ≥0.4 para usabilidad).

- Avanzado: COMET (0.81 de correlación con puntuaciones humanas) y MQM para una categorización detallada de errores.

-

Desafíos:

- Errores contextuales, idiomas con pocos recursos y datos de entrenamiento desactualizados.

- Ejemplo: Añadir datos de redes sociales mejoró la precisión de la traducción kurda en un 45%.

-

Soluciones:

- Los sistemas de aprendizaje activo reducen errores al marcar salidas de baja confianza.

- Combinar herramientas de IA con supervisión humana mejora las tasas de detección de defectos al 91%.

Comparación Rápida de Métricas:

| Métrica | Área de Enfoque | Caso de Uso y Umbral |

|---|---|---|

| BLEU | Precisión N-gram | Revisiones rápidas, puntuaciones ≥0.4 |

| TER | Distancia de edición | Calidad profesional, <9% pref |

| ROUGE | Medición de recuerdo | Validación de contenido, 0.3-0.5 |

| COMET | Evaluación semántica | Fuerte correlación (0.81) |

| MQM | Categorización de errores | Detalle a nivel empresarial |

Esta guía explica cómo las empresas pueden combinar automatización y experiencia humana para lograr traducciones escalables, precisas y culturalmente relevantes.

Métricas de Medición de Calidad

Las herramientas modernas combinan automatización con experiencia humana para ofrecer traducciones precisas y conscientes del contexto. Estas métricas están diseñadas para cumplir con objetivos clave como precisión semántica, consistencia terminológica y adaptación a matices culturales.

Métricas Básicas: BLEU, TER, ROUGE

Tres métricas principales forman la columna vertebral de la prueba de calidad de traducción:

| Métrica | Área de Enfoque | Caso de Uso y Umbral |

|---|---|---|

| BLEU | Precisión N-gram | Revisiones rápidas, puntuaciones ≥0.4 son utilizables |

| TER | Distancia de edición | Calidad profesional, <9% preferido |

| ROUGE | Medición de recuerdo | Validación de contenido, rango 0.3-0.5 |

Las traducciones que obtienen puntajes superiores a 0.6 en BLEU a menudo superan la calidad humana promedio. Sin embargo, un estudio de 2023 destacó las limitaciones de BLEU: BLEU de referencia única tenía una correlación débil con los juicios humanos (r=0.32), mientras que las configuraciones de referencia múltiple se desempeñaron mejor (r=0.68).

Nuevas Métricas: COMET y MQM

Los marcos más nuevos abordan lagunas en las métricas tradicionales. COMET, impulsado por redes neuronales, evalúa la semántica y logró una fuerte correlación de 0.81 con puntuaciones humanas en los benchmarks de WMT2022, mucho mejor que la correlación de 0.45 de BLEU.

MQM descompone los errores en categorías como precisión, fluidez y terminología, asignando pesos de severidad. Este enfoque detallado es especialmente útil para traducciones a nivel empresarial.

Pruebas de Máquinas vs. Humanas

Un enfoque equilibrado que combine tanto evaluación automática como humana es esencial. Los líderes de la industria han adoptado flujos de trabajo como este:

"Filtrado inicial TER → Evaluación semántica COMET → Post-edición humana para puntuaciones de COMET <0.8 → revisión final del cliente. Este proceso reduce los costos de evaluación en un 40% mientras mantiene un cumplimiento de calidad del 98%."

Para contenido altamente especializado, la intervención humana es indispensable. Las métricas emergentes ahora se enfocan en factores como consistencia contextual y captación del tono emocional, allanando el camino para enfrentar desafíos prácticos. Estos avances se discutirán más a fondo en la próxima sección sobre Problemas Comunes de Traducción.

Problemas Comunes de Traducción

Los datos de la industria señalan tres desafíos importantes que suelen surgir:

Contexto y Significado

Un significativo 38% de las traducciones evaluadas con métricas básicas de BLEU requieren intervención humana al tratar con expresiones idiomáticas. Este problema es especialmente notable en entornos profesionales.

"La mistraducción de un contrato de la UE de 'responsables conjunta y solidariamente' causó pérdidas de 2.8 millones de euros, debido a datos de entrenamiento legal incompletos. El análisis posterior al incidente mostró que agregar 15k documentos legales certificados redujo errores similares en un 78%"

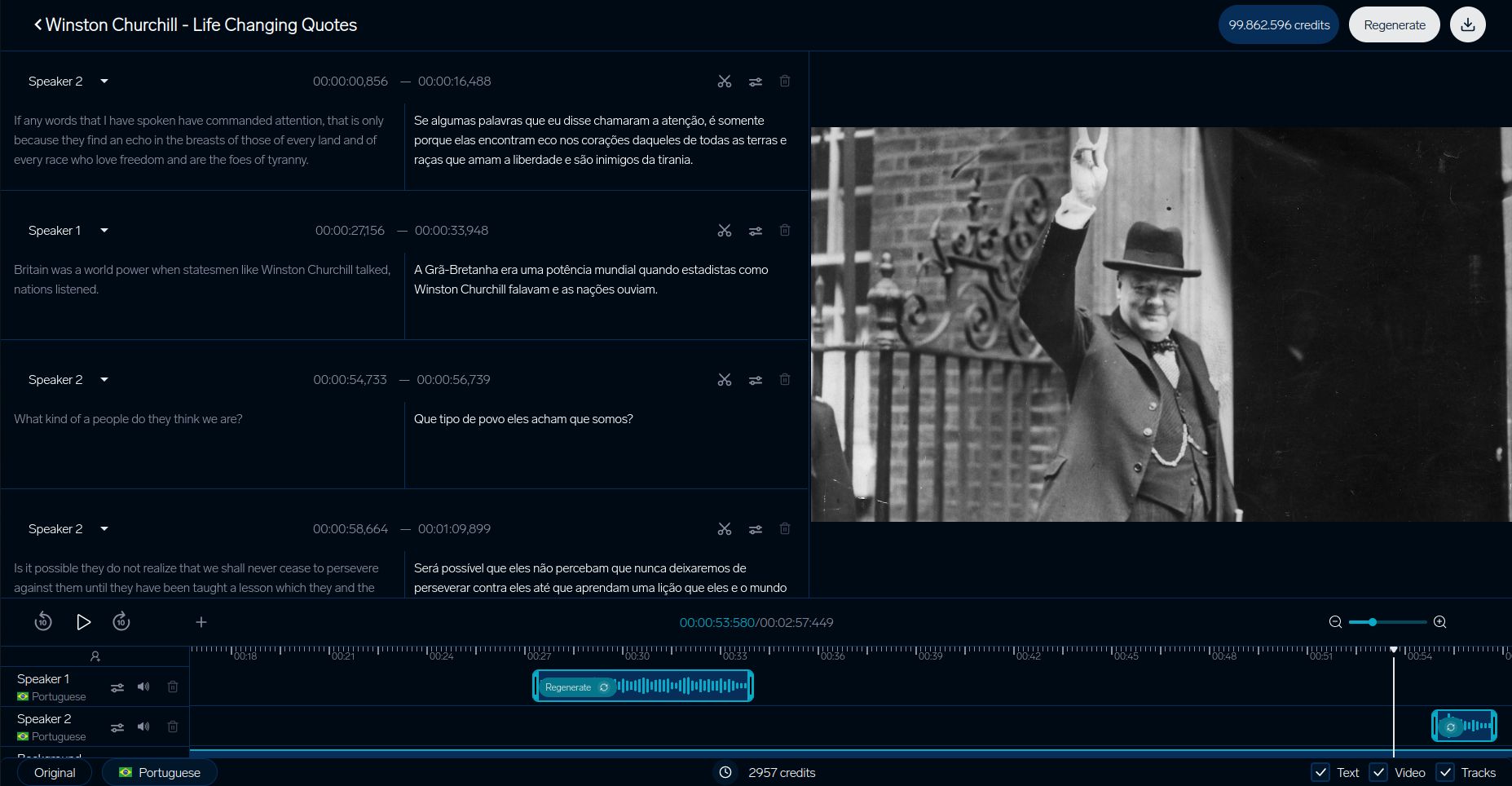

Herramientas como el analizador de contexto de video de DubSmart han logrado un 92% de precisión contextual al sincronizar pistas visuales con el diálogo traducido. Este enfoque ha reducido notablemente las mistraducciones de género en un 63%, gracias a su uso del reconocimiento de objetos en escenas.

Idiomas Menos Comunes

Los idiomas con menos recursos digitales enfrentan obstáculos únicos en la calidad de la traducción. Aquí hay un desglose de cómo la disponibilidad de recursos impacta en el desempeño:

| Nivel de Recurso | Impacto en la Calidad | Eficacia de la Solución |

|---|---|---|

| Idiomas con Alto Recurso | Desempeño base | Pruebas estándar suficientes |

| Idiomas con Medio Recurso | Reducción de calidad del 15% | La retrotraducción ayuda |

| Idiomas con Bajo Recurso | Puntuaciones TER 22% más altas | Se necesita aprendizaje por transferencia |

Un estudio de caso en kurdo destaca cómo añadir datos de redes sociales mejoró la precisión en un 45%. Además, el aprendizaje por transferencia de familias de idiomas relacionadas ha demostrado reducir los datos de entrenamiento requeridos en un 30%.

Calidad de los Datos de Entrenamiento

La calidad de los datos de entrenamiento juega un papel crucial en la precisión de la traducción, particularmente en campos especializados. Un estudio de 2024 encontró que el 68% de los errores de traducción médica se derivan de un sesgo hacia la terminología médica occidental en los conjuntos de datos de entrenamiento. Este desequilibrio es notorio, con una relación de 5:1 que favorece términos occidentales sobre conceptos de medicina tradicional.

Las traducciones técnicas también encuentran desafíos relacionados con datos desactualizados:

"Los glosarios técnicos de más de 3 años muestran tasas de error un 22% más altas. Un proyecto de traducción de manuales de semiconductores requirió actualizaciones mensuales para mantener <2% de errores en términos"

Los sistemas de aprendizaje activo que marcan términos desactualizados han demostrado eficacia, reduciendo las cargas de trabajo de revisión en un 37%, especialmente en dominios técnicos.

Estos desafíos subrayan la importancia de los métodos de prueba prácticos cubiertos en la siguiente sección para asegurar que la calidad de la traducción se mantenga alta.

Pruebas en la Práctica

Los métodos de prueba práctica abordan los desafíos de los datos de entrenamiento y el contexto a través de algunas estrategias enfocadas:

DubSmart Traducción de Video

El sistema de pruebas de DubSmart destaca cómo las plataformas de traducción de video aseguran calidad. Su proceso detallado se centra en alinear el contexto visual, abordando especialmente los problemas de mistraducción de género discutidos anteriormente:

| Componente | Métrica |

|---|---|

| Sincronización Labial | Retraso menor de 200ms |

| Coincidencia de Voz | 93% de similitud |

| Sincronización Visual | Desajuste menor de 5% |

Estudios de Caso Empresariales

Grandes empresas han creado sistemas de pruebas avanzados que combinan herramientas de IA con experiencia humana. El uso del marco MQM-DQF por parte de SAP es un ejemplo destacado:

"Al combinar productos de TM neural con equipos de validación lingüística, SAP logró una reducción del 40% en el esfuerzo de post-edición mientras mantenía tasas de precisión del 98%".

IKEA optimizó su proceso de localización de catálogos, reduciendo el tiempo al mercado en un 35% a través de una mezcla de validación humana y de IA.

Booking.com también demuestra el poder de las pruebas automatizadas. Su sistema maneja más de 1 mil millones de traducciones cada año en 45 idiomas, reduciendo los costos en un 40% mientras mantiene la calidad consistente para el contenido generado por usuarios.

Estos ejemplos resaltan cómo las empresas están mejorando la precisión, eficiencia y escalabilidad en las pruebas de traducción.

sbb-itb-f4517a0

Próximos Pasos en la Prueba de Traducción

A medida que los métodos de prueba mejoran, tres áreas clave están impulsando los estándares de calidad a nuevos niveles:

Transferencia de Tono y Emoción

Los sistemas modernos son ahora mejores en preservar los matices emocionales, gracias al marco EMO-BLEU, que tiene una correlación de Pearson de 0.73 con la percepción humana en comparación con el 0.41 de BLEU. Los modelos de transformadores multimodales han avanzado significativamente, manteniendo las emociones del hablante intactas. Estos sistemas pueden mantener variaciones de intensidad dentro de ±2dB en varios idiomas mientras gestionan marcadores emocionales complejos.

Traducción Basada en Contexto

Los sistemas conscientes del contexto están redefiniendo cómo se evalúa la calidad de la traducción. Un gran ejemplo es el Modo Contextual de DeepL, que utiliza seguimiento de entidades a nivel de documento y ajustes de formalidad en tiempo real.

Las pruebas para estos sistemas se han vuelto más avanzadas, centrándose en puntos de referencia clave:

| Componente de Prueba | Benchmark Actual | Enfoque de Medición |

|---|---|---|

| Respuesta de Primera Palabra | <900ms | Precisión de inicio del habla |

| Calidad de Transmisión | <4 palabras de retraso | Consistencia de búfer |

| Alineación de Contexto | >0.8 puntuación | Adaptación dinámica |

Estos sistemas manejan más de 100 millones de pares de oraciones contextuales, completos con anotaciones en capas.

Sistemas de IA de Aprendizaje

Los sistemas de traducción que se mejoran a sí mismos están cambiando cómo se prueba la calidad al integrar retroalimentación continua. El marco de Orq.ai destaca este cambio, recortando costos de post-edición en un 37% trimestral mediante:

"Arquitecturas de aprendizaje activo que marcan segmentos de baja confianza con puntuaciones de COMET por debajo de 0.6, presentando alternativas a través de la interfaz de tipología de errores de MQM y actualizando pesos del modelo cada dos semanas usando muestras validadas".

Estos sistemas identifican automáticamente traducciones de baja confianza (COMET <0.6) y actualizan sus modelos cada dos semanas usando muestras validadas por lingüistas. Sin embargo, también enfrentan desafíos éticos. La investigación del MIT muestra un 22% de desviación en la neutralidad de género sin medidas adecuadas de des-bias. Este problema se relaciona con los problemas de datos de entrenamiento sesgados, subrayando la necesidad de protocolos de monitoreo actualizados.

Herramientas de la industria como el Marco de Calidad Dinámica v3.1 de TAUS ayudan a garantizar que estos sistemas cumplan con estándares en evolución.

Resumen

Métodos de Pruebas Clave

Las técnicas de prueba modernas han crecido más allá de la simple coincidencia de n-gramas y ahora se enfocan en el análisis contextual. Las métricas tradicionales como BLEU, TER y ROUGE todavía proporcionan una base para evaluaciones básicas. Sin embargo, métodos más nuevos como COMET y MQM han demostrado alinearse más estrechamente con el juicio humano.

Por ejemplo, el marco EMO-BLEU ha demostrado que las métricas automáticas pueden alcanzar un 73% de correlación con el juicio humano al evaluar qué tan bien se conserva el contenido emocional. Hoy en día, las pruebas de calidad enfatizan no solo la precisión técnica, sino también la importancia de alinearse con matices culturales, un objetivo clave para implementaciones a nivel empresarial.

Herramientas y Recursos

Las pruebas de traducción modernas a menudo usan plataformas que reúnen múltiples métodos de evaluación. Un ejemplo es DubSmart, que ofrece una amplia gama de características de prueba y sistemas avanzados de verificación de contenido.

Componentes clave de una prueba efectiva incluyen:

- Puertas de calidad basadas en COMET con umbrales por debajo de 0.6

- Glosarios que han sido revisados por relevancia cultural

- Sistemas de aprendizaje activo actualizados cada dos semanas

Para campos especializados como el contenido médico, legal y técnico, las pruebas combinan métricas generales con aquellas específicas de la industria. Este enfoque ha llevado a una mejora del 22% en calidad al usar sistemas de evaluación combinados.

Preguntas Frecuentes

¿Cuáles son las desventajas de la puntuación BLEU?

La puntuación BLEU, aunque ampliamente utilizada, tiene limitaciones notables cuando se aplica a la evaluación de la calidad de la traducción. Aquí sus principales debilidades:

| Limitación | Efecto en la Evaluación de Traducciones |

|---|---|

| Ceguera Semántica | Se enfoca solo en las coincidencias de palabras, ignorando el significado o el contexto |

| Penalizaciones de Diversidad de Frases | Penaliza traducciones válidas que usan frases diferentes de los textos de referencia |

Para abordar estos problemas, muchas plataformas de localización de video utilizan una combinación de métodos de evaluación. Por ejemplo, el analizador de contexto de DubSmart combina múltiples métricas para proporcionar una evaluación más precisa.

"Mientras que BLEU proporciona mediciones básicas, las pruebas exhaustivas requieren análisis semántico y contextual, especialmente para traducciones cruciales para el negocio."

Para una mejor precisión, los expertos sugieren:

- COMET para evaluar significado y semántica

- Validación humana para comprender matices culturales

- Herramientas específicas del idioma para manejar estructuras gramaticales complejas

Este enfoque en capas, como el utilizado por DubSmart, combina herramientas automáticas con conocimientos humanos para asegurar que las traducciones cumplan tanto con estándares técnicos como contextuales.