Ostateczny Przewodnik po Testowaniu Jakości Tłumaczeń AI

Kluczowe Punkty:

- Dlaczego to ważne: Jakość tłumaczenia wpływa na zaufanie, zgodność i przychody. Branże takie jak medycyna (99,9% dokładności) i prawo (98% dokładności) wymagają precyzji.

-

Główne Cele Testowania:

- Dokładność Semantyczna: Narzędzia jak COMET zgadzają się z ocenami ludzkimi w 89% przypadków.

- Spójność Terminologii: Pole prawne żąda 99,5% spójności terminologicznej.

- Adaptacja Kulturowa: Dostosowane treści mogą zwiększyć retencję użytkowników o 34%.

-

Mierniki i Narzędzia:

- Tradycyjne: BLEU, TER, ROUGE (np. BLEU ≥0,4 dla użyteczności).

- Zaawansowane: COMET (0,81 korelacja z ocenami ludzi) i MQM dla szczegółowej kategoryzacji błędów.

-

Wyzwania:

- Błędy kontekstowe, języki o niskich zasobach i przestarzałe dane szkoleniowe.

- Przykład: Dodanie danych z mediów społecznościowych poprawiło dokładność tłumaczeń na kurdyjski o 45%.

-

Rozwiązania:

- Systemy uczące się aktywnie redukują błędy poprzez oznaczanie wyjść o niskiej pewności.

- Łączenie narzędzi AI z nadzorem ludzkim poprawia wskaźniki wykrywania defektów do 91%.

Szybkie Porównanie Mierników:

| Miernik | Obszar Skupienia | Przypadek użycia i progi |

|---|---|---|

| BLEU | Precyzja N-gramu | Szybkie kontrole, wyniki ≥0,4 |

| TER | Dystans edycyjny | Profesjonalna jakość, <9% preferowane |

| ROUGE | Pomiary przypomnień | Weryfikacja treści, 0,3-0,5 |

| COMET | Ewaluacja semantyczna | Silna korelacja (0,81) |

| MQM | Kategoryzacja błędów | Szczegółowość na poziomie przedsiębiorstwa |

Ten przewodnik wyjaśnia, jak firmy mogą łączyć automatyzację i ludzką ekspertyzę, aby osiągnąć skalowalne, dokładne i kulturowo odpowiednie tłumaczenia.

Mierniki Pomiaru Jakości

Nowoczesne narzędzia łączą automatyzację z ludzką wiedzą, aby dostarczać dokładne i świadome kontekstu tłumaczenia. Te mierniki są zaprojektowane w celu spełniania kluczowych celów, jak dokładność semantyczna, spójność terminologiczna i adaptacja do niuansów kulturowych.

Podstawowe Mierniki: BLEU, TER, ROUGE

Trzy kluczowe mierniki stanowią fundament testowania jakości tłumaczeń:

| Miernik | Obszar Skupienia | Przypadek użycia i progi |

|---|---|---|

| BLEU | Precyzja N-gramu | Szybkie kontrole, wyniki ≥0,4 są użyteczne |

| TER | Dystans edycyjny | Profesjonalna jakość, <9% preferowany |

| ROUGE | Pomiary przypomnień | Weryfikacja treści, zakres 0,3-0,5 |

Tłumaczenia uzyskujące wyniki powyżej 0,6 na BLEU często przewyższają średnią jakość ludzką. Jednak badanie z 2023 roku podkreśliło ograniczenia BLEU: jednoreferencyjny BLEU miał słabą korelację z ocenami ludzi (r=0,32), podczas gdy układy wieloreferencyjne działały lepiej (r=0,68).

Nowe Mierniki: COMET i MQM

Nowsze ramy wypełniają luki w tradycyjnych miernikach. COMET, oparty na sieciach neuronowych, ocenia semantykę i osiągnął silną korelację 0,81 z ocenami ludzkimi w benchmarkach WMT2022 - znacznie lepiej niż korelacja BLEU wynosząca 0,45.

MQM dzieli błędy na kategorie takie jak dokładność, płynność i terminologia, przypisując wagi ciężkości. To szczegółowe podejście jest szczególnie przydatne w tłumaczeniach na poziomie przedsiębiorstwa.

Testowanie Maszynowe vs Ludzkie

Zbalansowane podejście łączące ocenę maszynową i ludzką jest kluczowe. Liderzy branży przyjęli takie przepływy pracy:

"Początkowe filtrowanie TER → semantyczna ewaluacja COMET → ludzka edycja postprodukcyjna dla wyników COMET <0,8 → ostateczna ocena klienta. Ten proces zmniejsza koszty oceny o 40%, utrzymując 98% zgodność jakości."

Dla wysoko wyspecjalizowanej treści udział człowieka jest niezbędny. Nowe mierniki koncentrują się teraz na czynnikach jak spójność kontekstowa i uchwycenie emocjonalnego tonu, otwierając drogę dla radzenia sobie z praktycznymi wyzwaniami. Te postępy będą omówione dalej w następnej sekcji o Typowych Problemach z Tłumaczeniem.

Typowe Problemy z Tłumaczeniem

Dane branżowe wskazują na trzy główne wyzwania, które często się pojawiają:

Kontekst i Znaczenie

Znaczące 38% tłumaczeń ocenionych na podstawie podstawowych mierników BLEU wymaga interwencji ludzkiej w przypadku wyrażeń idiomatycznych. Problem ten jest szczególnie wyraźny w środowiskach profesjonalnych.

"Tłumaczenie umowy UE z błędnym określeniem 'odpowiedzialność solidarna i kilku' spowodowało straty w wysokości 2,8 miliona euro, czego przyczyną były niekompletne dane szkoleniowe dotyczące prawa. Analiza po incydencie wykazała, że dodanie 15 tysięcy certyfikowanych dokumentów prawnych zmniejszyło podobne błędy o 78%"

Narzędzia jak analizator kontekstu wideo DubSmart osiągnęły 92% dokładności kontekstowej, synchronizując wskazówki wizualne z przetłumaczonym dialogiem. To podejście znacznie zmniejszyło błędne tłumaczenia dotyczące płci o 63% dzięki wykorzystaniu rozpoznawania obiektów scenicznych.

Rzadziej Spotykane Języki

Języki z mniejszą ilością cyfrowych zasobów napotykają unikalne przeszkody w jakości tłumaczeń. Oto analiza, jak dostępność zasobów wpływa na wydajność:

| Poziom Zasobów | Wpływ na Jakość | Skuteczność Rozwiązania |

|---|---|---|

| Języki z Wysokimi Zasobami | Wydajność bazowa | Standardowe testy wystarczające |

| Języki ze Średnimi Zasobami | 15% zmniejszenie jakości | Tłumaczenie zwrotne pomaga |

| Języki z Niskimi Zasobami | 22% wyższe wyniki TER | Potrzebne przenoszenie nauki |

Studium przypadku języka kurdyjskiego podkreśla, jak dodanie danych z mediów społecznościowych poprawiło dokładność o 45%. Dodatkowo, przenoszenie nauki od pokrewnych rodzin językowych zredukowało potrzebne dane szkoleniowe o 30%.

Jakość Danych Szkoleniowych

Jakość danych szkoleniowych odgrywa kluczową rolę w dokładności tłumaczenia, szczególnie w wyspecjalizowanych dziedzinach. Badanie z 2024 roku wykazało, że 68% błędów w tłumaczeniach medycznych wynikało z tendencji do zachodniej terminologii medycznej w zestawach danych do nauki. Ta nierównowaga jest wyraźna z proporcją 5:1 na korzyść zachodnich terminów w porównaniu z koncepcjami medycyny tradycyjnej.

Tłumaczenia techniczne również napotykają wyzwania związane z przestarzałymi danymi:

"Słowniki techniczne starsze niż 3 lata wykazują 22% wyższe wskaźniki błędów. Projekt tłumaczenia instrukcji do półprzewodników wymagał aktualizacji co miesiąc, aby utrzymać <2% błędów terminologicznych"

Systemy uczące się aktywnie, które oznaczają przestarzałe terminy, okazały się skuteczne, zmniejszając obciążenie pracą o 37%, szczególnie w domenach technicznych.

Te wyzwania podkreślają znaczenie praktycznych metod testowania omawianych w następnej sekcji, aby zapewnić, że jakość tłumaczeń pozostaje wysoka.

Praktyka Testowania

Praktyczne metody testowania odnoszą się do wyzwań związanych z danymi szkoleniowymi i kontekstem poprzez kilka skoncentrowanych strategii:

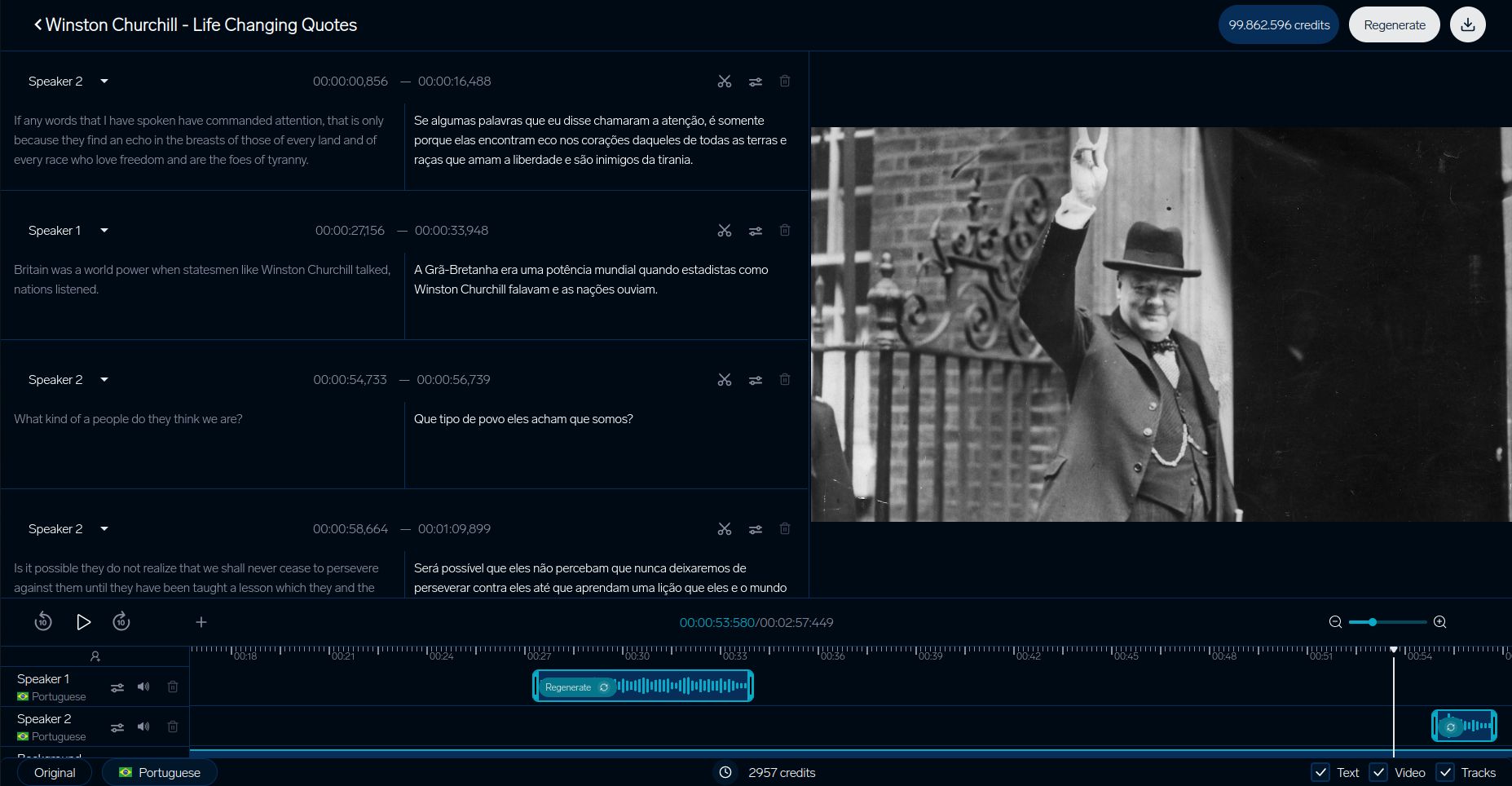

DubSmart Tłumaczenia Wideo

System testowania DubSmart podkreśla, jak platformy tłumaczeń wideo zapewniają jakość. Ich szczegółowy proces koncentruje się na zestrajaniu kontekstu wizualnego, szczególnie rozwiązując kwestie błędnych tłumaczeń dotyczących płci omawianych wcześniej:

| Składnik | Miernik |

|---|---|

| Synchronizacja Ruchu Warg | Mniej niż 200ms opóźnienia |

| Dopasowanie Głosu | 93% podobieństwo |

| Synchronizacja Wizualna | Mniej niż 5% niespójności |

Studia Przypadków Biznesowych

Duże firmy stworzyły zaawansowane systemy testowania, które łączą narzędzia AI z ludzką ekspertyzą. Wyróżniającym się przykładem jest zastosowanie przez SAP ramy MQM-DQF:

"Łącząc wyjście neuronowego tłumaczenia maszynowego z zespołami walidacyjnymi lingwistów, SAP zredukował wysiłek post-edytorski o 40%, jednocześnie utrzymując 98% wskaźniki dokładności".

IKEA usprawniła proces lokalizacji katalogów, skracając czas na wprowadzenie na rynek o 35% dzięki połączeniu ludzkiej i AI walidacji.

Booking.com także demonstruje moc automatycznego testowania. Ich system obsługuje ponad 1 miliard tłumaczeń rocznie w 45 językach, redukując koszty o 40%, jednocześnie utrzymując jakość dla treści generowanych przez użytkowników.

Te przykłady ilustrują, jak firmy poprawiają dokładność, efektywność i skalowalność w testowaniu tłumaczeń.

sbb-itb-f4517a0

Następne Kroki w Testowaniu Tłumaczeń

W miarę jak metody testowania się rozwijają, trzy kluczowe obszary podnoszą standardy jakości na nowe poziomy:

Przenoszenie Tonu i Emocji

Nowoczesne systemy stają się lepsze w zachowywaniu niuansów emocjonalnych dzięki ramach EMO-BLEU, które mają korelację Pearsona 0,73 z percepcją ludzi w porównaniu do korelacji BLEU wynoszącej 0,41. Wielomodalne modele transformatorowe znacznie się rozwinęły, zachowując niezmiennie emocje mówiącego. Systemy te mogą utrzymywać wariacje intensywności w granicach ±2dB w różnych językach, jednocześnie zarządzając złożonymi markami emocjonalnymi.

Tłumaczenie Uwzględniające Kontekst

Systemy uwzględniające kontekst zmieniają sposób oceny jakości tłumaczeń. Świetnym przykładem jest tryb kontekstowy DeepL, który korzysta ze śledzenia jednostek na poziomie dokumentu i dynamicznych dostosowań formalności w czasie rzeczywistym.

Testowanie dla tych systemów stało się bardziej zaawansowane, skupiając się na kluczowych benchmarkach:

| Składnik Testowania | Bieżący Benchmark | Skupienie na Miarze |

|---|---|---|

| Odpowiedź Pierwszego Słowa | <900ms | Dokładność rozpoczęcia mowy |

| Jakość Strumieniowania | <4 zaniki słów | Spójność bufora |

| Wyrównanie Kontekstowe | >0,8 wynik | Dostosowanie dynamiczne |

Systemy te obsługują ponad 100 milionów kontekstowych par zdań, kompletne z warstwowymi adnotacjami.

Systemy Uczące AI

Systemy tłumaczeniowe, które same się doskonalą, zmieniają sposób testowania jakości poprzez integrację ciągłej informacji zwrotnej. Ramy Orq.ai podkreślają tę zmianę, obniżając koszty post-edytorskie o 37% kwartalnie poprzez:

"Architektury uczące się aktywnie, które oznaczają segmenty o niskiej pewności z wynikami COMET poniżej 0,6, przedstawiają alternatywy za pomocą interfejsu typologii błędów MQM i aktualizują wagi modeli co dwa tygodnie za pomocą zweryfikowanych próbek".

Systemy te automatycznie identyfikują tłumaczenia o niskiej pewności (COMET <0,6) i aktualizują swoje modele co dwa tygodnie za pomocą próbek zweryfikowanych przez lingwistów. Jednakże, muszą także sprostać wyzwaniom etycznym. Badania MIT wykazują 22% dryft w neutralności płci bez odpowiednich środków debiasujących. Problem ten wiaże się z problemami z uprzedzonymi danymi do nauki, co podkreśla potrzebę aktualizowanych protokołów monitorowania.

Narzędzia branżowe, takie jak TAUS Dynamic Quality Framework v3.1, pomagają zapewnić, że te systemy spełniają zmieniające się standardy.

Podsumowanie

Kluczowe Metody Testowania

Nowoczesne techniki testowania przeszły od prostego dopasowywania n-gramów i obecnie skupiają się na analizie kontekstowej. Tradycyjne mierniki jak BLEU, TER i ROUGE nadal stanowią podstawę do oceny bazowej. Jednak nowsze metody jak COMET i MQM okazały się bardziej zgodne z oceną ludzką.

Na przykład rama EMO-BLEU pokazała, że automatyczne mierniki mogą osiągnąć 73% korelację z oceną ludzką przy ocenie, jak dobrze zachowany jest emocjonalny przekaz. Dziś testowanie jakości koncentruje się nie tylko na technicznej dokładności, ale także na znaczeniu zgodności z niuansami kulturowymi, co jest kluczowym celem dla implementacji na poziomie przedsiębiorstwa.

Narzędzia i Zasoby

Nowoczesne testowanie tłumaczeń często korzysta z platform, które łączą różne metody oceny. Przykładem jest DubSmart, oferujący szeroki zakres funkcji testowania i zaawansowanych systemów weryfikacji treści.

Kluczowe elementy skutecznego testowania to:

- Bramki jakości oparte na COMET z progami poniżej 0,6

- Słowniki, które zostały zrewidowane pod kątem odniesień kulturowych

- Systemy uczące się aktywnie aktualizowane co dwa tygodnie

W wyspecjalizowanych dziedzinach jak medycyna, prawo i treści techniczne testowanie łączy mierniki ogólne z tymi specyficznymi dla branży. Takie podejście doprowadziło do poprawy jakości o 22% przy użyciu złożonych systemów oceny.

FAQ

Jakie są wady wskaźnika BLEU?

Wskaźnik BLEU, chociaż szeroko stosowany, ma zauważalne ograniczenia, gdy jest stosowany do oceny jakości tłumaczenia. Oto jego główne słabości:

| Ograniczenie | Wpływ na Ocenę Tłumaczenia |

|---|---|

| Ślepota Semantyczna | Skupia się tylko na zgodności słów, ignorując znaczenie czy kontekst |

| Kary za Różnorodność Sformułowań | Kara za poprawne tłumaczenia, które wykorzystują inne sformułowania niż w tekstach odniesienia |

Aby rozwiązać te problemy, wiele platform do lokalizacji wideo używa mieszanki metod oceny. Na przykład, analizator kontekstu DubSmart łączy wiele mierników, aby zapewnić bardziej dokładną ocenę.

"Podczas gdy BLEU dostarcza miar bazowych, kompleksowe testowanie wymaga analizy semantycznej i kontekstowej - zwłaszcza w przypadku tłumaczeń krytycznych dla biznesu."

Dla lepszej dokładności eksperci sugerują:

- COMET do oceny znaczenia i semantyki

- Walidacja ludzka dla zrozumienia niuansów kulturowych

- Narzędzia specyficzne dla języka dla radzenia sobie z złożonymi strukturami gramatycznymi

To warstwowe podejście, jakie stosuje DubSmart, łączy narzędzia automatyczne z ludzkimi spostrzeżeniami, aby zapewnić, że tłumaczenia spełniają zarówno standardy techniczne, jak i kontekstowe.