Ultieme Gids voor Kwaliteitstesten van AI Vertalingen

Belangrijkste Inzichten:

- Waarom Het Belangrijk Is: De kwaliteit van vertalingen beïnvloedt vertrouwen, naleving en inkomsten. Sectoren zoals de medische (99,9% nauwkeurigheid) en juridische (98% nauwkeurigheid) vereisen precisie.

-

Hoofddoelen van Testen:

- Semantische Nauwkeurigheid: Tools zoals COMET komen 89% van de tijd overeen met menselijke beoordelingen.

- Consistentie van Terminologie: De juridische sector eist 99,5% term consistentie.

- Culturele Aanpassing: Aangepaste inhoud kan het gebruikersbehoud met 34% verhogen.

-

Metingen & Tools:

- Traditioneel: BLEU, TER, ROUGE (bijv. BLEU ≥0.4 voor bruikbaarheid).

- Geavanceerd: COMET (0.81 correlatie met menselijke scores) en MQM voor gedetailleerde categorisatie van fouten.

-

Uitdagingen:

- Contextuele fouten, talen met weinig bronnen, en verouderde trainingsdata.

- Voorbeeld: Het toevoegen van sociale mediagegevens verbeterde de nauwkeurigheid van Koerdische vertalingen met 45%.

-

Oplossingen:

- Actieve leersystemen verminderen fouten door outputs met lage vertrouwensscores te markeren.

- Het combineren van AI-tools met menselijke controle verhoogt foutdetectie tot 91%.

Snelle Vergelijking van Metingen:

| Meting | Focusgebied | Gebruik & Drempel |

|---|---|---|

| BLEU | N-gram precisie | Snelle controles, scores ≥0.4 |

| TER | Bewerkingsafstand | Professioneel niveau, <9% voorkeur |

| ROUGE | Herinneringsmeting | Inhoudsvalidatie, 0.3-0.5 |

| COMET | Semantische evaluatie | Sterke correlatie (0.81) |

| MQM | Foutcategorisatie | Detailniveau op ondernemingsniveau |

Deze gids legt uit hoe bedrijven automatisering en menselijke expertise kunnen combineren om schaalbare, nauwkeurige en cultureel relevante vertalingen te bereiken.

Kwaliteitsmeetmetriek

Moderne tools combineren automatisering met menselijke expertise om nauwkeurige en contextbewuste vertalingen te leveren. Deze metrieken zijn ontworpen om belangrijke doelstellingen zoals semantische nauwkeurigheid, terminologieconsistentie en aanpassing aan culturele nuances te behalen.

Basis Metriek: BLEU, TER, ROUGE

Drie kernmetriek vormen de ruggengraat van kwaliteitstesten van vertalingen:

| Meting | Focusgebied | Gebruik & Drempel |

|---|---|---|

| BLEU | N-gram precisie | Snelle controles, scores ≥0.4 zijn bruikbaar |

| TER | Bewerkingsafstand | Professioneel niveau, <9% voorkeur |

| ROUGE | Herinneringsmeting | Inhoudsvalidatie, 0.3-0.5 bereik |

Vertalingen met een score boven 0.6 op BLEU overtreffen vaak de gemiddelde menselijke kwaliteit. Een studie uit 2023 benadrukte echter de beperkingen van BLEU: blauwe enkelvoudige referentie had een zwakke correlatie met menselijke beoordelingen (r=0.32), terwijl opstellingen met meerdere referenties beter presteerden (r=0.68).

Nieuwe Metriek: COMET en MQM

Nieuwere raamwerken pakken lacunes in traditionele metriek aan. COMET, aangedreven door neurale netwerken, evalueert semantiek en behaalde een sterke 0.81 correlatie met menselijke scores in WMT2022 benchmarks - veel beter dan BLEU's 0.45 correlatie.

MQM verdeelt fouten in categorieën zoals nauwkeurigheid, vloeiendheid en terminologie, en kent gewichten toe aan ernst. Deze gedetailleerde benadering is vooral nuttig voor vertalingen op ondernemingsniveau.

Machine vs. Menselijke Tests

Een gebalanceerde aanpak die machine- en menselijke evaluatie combineert, is essentieel. Marktleiders hebben workflows als volgt geïmplementeerd:

"Initiële TER-filtering → COMET semantische evaluatie → menselijke nabewerking voor COMET scores <0.8 → definitieve klantbeoordeling. Dit proces reduceert evaluatiekosten met 40% terwijl 98% kwaliteitsnaleving behouden blijft."

Voor zeer gespecialiseerde inhoud is menselijke betrokkenheid onmisbaar. Opkomende metriek richten zich nu op factoren zoals contextuele consistentie en het vangen van emotionele toon, wat de weg vrijmaakt voor praktische uitdagingen die verder worden besproken in de volgende sectie over Veelvoorkomende Vertaalproblemen.

Veelvoorkomende Vertaalproblemen

Branchestatistieken wijzen op drie grote uitdagingen die vaak optreden:

Context en Betekenis

Significant 38% van de vertalingen beoordeeld met basismetriek van BLEU hebben menselijke interventie nodig wanneer het gaat om idiomatische uitdrukkingen. Dit probleem is vooral prominent in professionele omgevingen.

"Een verkeerde vertaling van een EU-contract van 'gezamenlijk en hoofdelijk aansprakelijk' veroorzaakte een verlies van €2,8 miljoen, terug te voeren op onvolledige juridische trainingsgegevens. Analyse na het incident toonde aan dat het toevoegen van 15.000 gecertificeerde juridische documenten soortgelijke fouten met 78% verminderde"

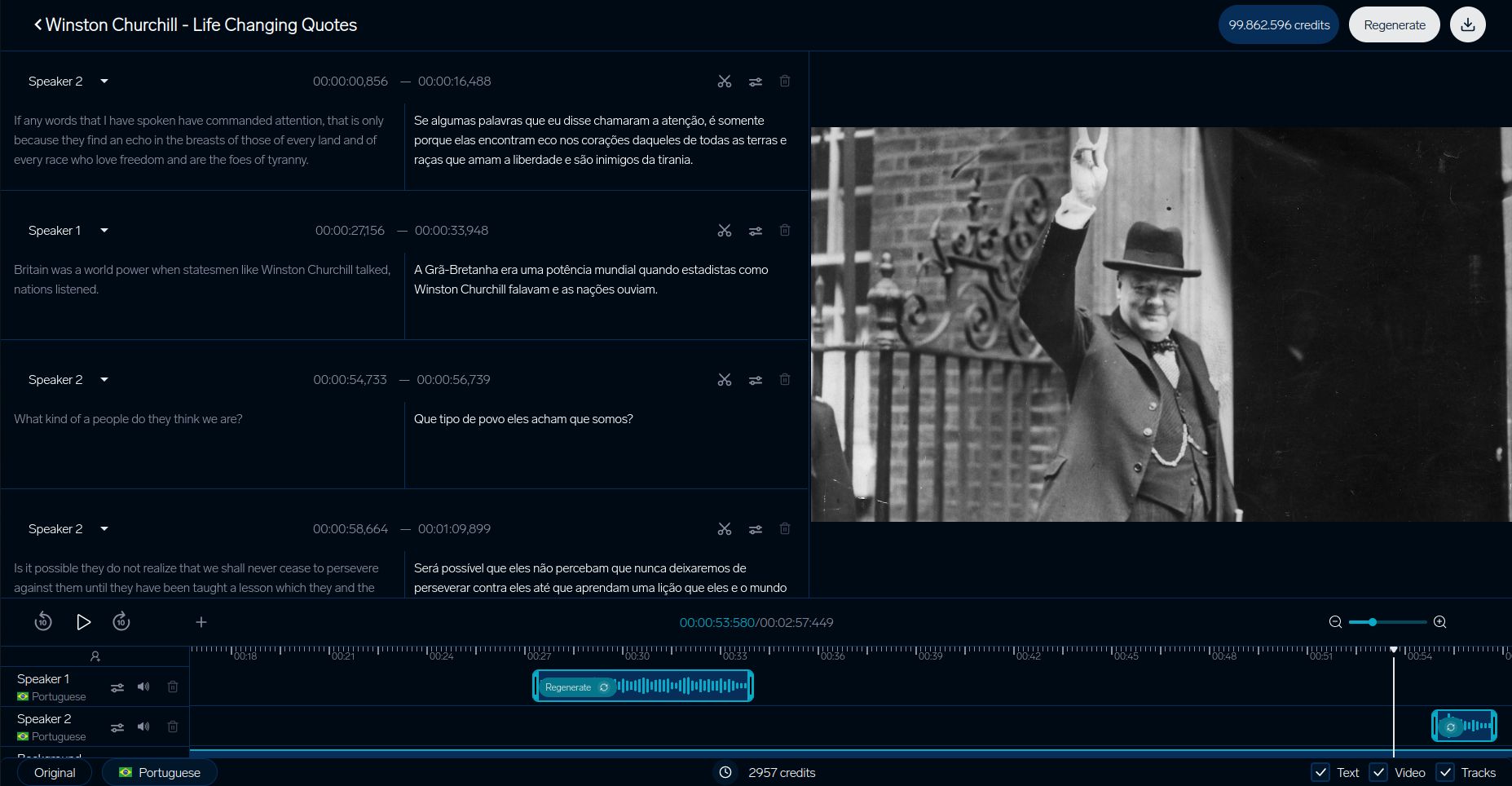

Tools zoals DubSmart's video-context analyzer hebben 92% contextuele nauwkeurigheid bereikt door visuele aanwijzingen te synchroniseren met vertaald dialoog. Deze benadering heeft geslachtvertalingen met 63% verminderd, dankzij het gebruik van scène-object herkenning.

Minder Gebruikelijke Talen

Talen met minder digitale bronnen ondervinden unieke hinderpalen in vertalingskwaliteit. Hier is een overzicht van hoe de beschikbaarheid van bronnen prestaties beïnvloedt:

| Bronniveau | Impact op Kwaliteit | Effectiviteit van Oplossing |

|---|---|---|

| Hoogbron Talen | Basisprestaties | Standaard testen voldoende |

| Middenbron Talen | 15% kwaliteitsvermindering | Terugvertaling helpt |

| Laagbron Talen | 22% hogere TER scores | Overdrachtleren nodig |

Een casestudy van de Koerdische taal benadrukt hoe het toevoegen van sociale media data de nauwkeurigheid met 45% verbeterde. Daarnaast heeft overdrachtleren van gerelateerde taalfamilies de benodigde trainingsdata met 30% verminderd.

De Kwaliteit van Trainingsdata

De kwaliteit van trainingsdata speelt een cruciale rol in vertalingsnauwkeurigheid, vooral op gespecialiseerde gebieden. Een studie uit 2024 ontdekte dat 68% van de medische vertaalfouten voortkwamen uit een vooringenomenheid ten gunste van westerse medische terminologie in trainingsdatasets. Deze onevenwichtigheid is groot, met een verhouding van 5:1 in het voordeel van Westerse termen boven traditionele medische concepten.

Technische vertalingen ondervinden ook uitdagingen die verband houden met verouderde data:

"Technische glossaria ouder dan 3 jaar laten 22% hogere foutpercentages zien. Een project voor de vertaling van een halfgeleiderhandleiding vereiste maandelijkse updates om <2% termfouten te behouden"

Actieve leersystemen die verouderde termen signaleren hebben zich effectief bewezen, met name in technische domeinen, doordat ze herzieningswerk verlagen met 37%.

Deze uitdagingen onderstrepen het belang van de praktische testmethoden die aan bod komen in de volgende sectie om ervoor te zorgen dat de vertaalkwaliteit hoog blijft.

Testen in de Praktijk

Praktische testmethoden pakken de uitdagingen van trainingsdata en context aan met een paar gerichte strategieën:

DubSmart Videovertalingen

DubSmart's testsysteem belicht hoe videovertaalsystemen kwaliteit waarborgen. Hun gedetailleerde proces richt zich op het afstemmen van visuele context, met name gericht op kwesties van geslachtvertalingen die eerder besproken zijn:

| Component | Meting |

|---|---|

| Lip-synchronisatie | Minder dan 200ms vertraging |

| Stemovereenkomst | 93% overeenkomst |

| Visuele Synchronisatie | Minder dan 5% mismatch |

Zakelijke Casestudies

Grote bedrijven hebben geavanceerde testsystemen gecreëerd die AI-tools combineren met menselijke expertise. SAP’s gebruik van het MQM-DQF raamwerk is een opvallend voorbeeld:

"Door neurale MT-resultaten te combineren met taalkundige validatieteams, behaalde SAP een vermindering van 40% in nabewerkingsinspanningen, terwijl nauwkeurigheidspercentages van 98% behouden bleven".

IKEA stroomlijnde zijn cataloguslokalisatieproces, waardoor de tijd-naar-markt met 35% werd verkort door een combinatie van menselijke en AI-validatie.

Booking.com laat ook de kracht van geautomatiseerde tests zien. Hun systeem verwerkt jaarlijks meer dan 1 miljard vertalingen in 45 talen, wat kosten verlaagt met 40%, terwijl de kwaliteit consistent blijft voor door gebruikers gegenereerde inhoud.

Deze voorbeelden benadrukken hoe bedrijven de nauwkeurigheid, efficiëntie en schaalbaarheid in vertaaltesten verbeteren.

sbb-itb-f4517a0

Volgende Stappen in Vertaaltesten

Naarmate testmethoden verbeteren, dringen drie kerngebieden de kwaliteitsnormen naar nieuwe hoogten:

Overdracht van Toon en Emotie

Moderne systemen zijn nu beter in het behouden van emotionele nuances dankzij het EMO-BLEU raamwerk, dat een Pearsoncorrelatie van 0.73 heeft met menselijke perceptie vergeleken met BLEU’s 0.41. Multi-modale transformer modellen zijn aanzienlijk verbeterd bij het behouden van de emoties van een spreker. Deze systemen kunnen intensiteitsvariaties binnen ±2dB over talen houden, terwijl ze complexe emotionele markeringen beheren.

Contextgebaseerde Vertaling

Contextbewuste systemen transformeren hoe vertaalkwaliteit wordt beoordeeld. Een groot voorbeeld is DeepL’s Context Mode, die gebruik maakt van document-niveau entiteitstracking en realtime formaliteitaanpassingen.

Het testen van deze systemen is geavanceerder geworden, met de nadruk op belangrijke maatstaven:

| Testcomponent | Huidige Benchmark | Maatstaven Focus |

|---|---|---|

| Eerste-woord Reactie | <900ms | Nauwkeurigheid van spraakstart |

| Streaming Kwaliteit | <4 woord vertraging | Buffermassa consistentie |

| Contextuele Afstemming | >0.8 score | Dynamische Aanpassing |

Deze systemen verwerken meer dan 100 miljoen contextuele zinnenparen, compleet met gelaagde annotaties.

Lerende AI Systemen

Vertaal systemen die zichzelf verbeteren veranderen de manier waarop kwaliteit getoetst wordt door inclusie van continue feedback. Orq.ai’s framework benadrukt deze verschuiving, door de nabewerkingskosten ieder kwartaal met 37% te verlagen via:

"Actieve leerarchitecturen die lage-zelfvertrouwensegmenten markeren met COMET scores onder de 0.6, alternatieven presenteren via MQM fouttypologie UI en modelgewichten biwekelijks updaten met gevalideerde samples".

Deze systemen identificeren automatisch lage-zelfvertrouwen vertalingen (COMET <0.6) en updaten hun modellen elke twee weken met door taalkundigen gevalideerde samples. Ze ervaren echter ook ethische uitdagingen. Onderzoek van MIT toont een 22% verschuiving in gender neutraliteit aan zonder juiste debiasing maatregelen. Dit probleem houdt verband met problemen van bevooroordeelde trainingsdata, wat de noodzaak onderstreept van bijgewerkte monitoringprotocollen.

Industrietools zoals het TAUS Dynamische Kwaliteitsraamwerk v3.1 helpen deze systemen te voldoen aan veranderende normen.

Samenvatting

Belangrijkste Testmethoden

Moderne testtechnieken zijn verder geëvolueerd dan eenvoudige n-gram overeenstemming en richten zich nu op contextanalyse. Traditionele metriek zoals BLEU, TER, en ROUGE bieden nog steeds een basis voor fundamentele evaluaties. Nieuwe methoden zoals COMET en MQM hebben echter bewezen dichter bij menselijke oordelen te staan.

Zo heeft het EMO-BLEU raamwerk aangetoond dat geautomatiseerde metriek een 73% correlatie kan bereiken met menselijke oordelen bij het evalueren van hoe emotionele inhoud behouden blijft. Tegenwoordig legt kwaliteitstesten niet alleen de nadruk op technische nauwkeurigheid, maar ook op het belang van afstemming op culturele nuances, een belangrijk doel voor implementaties op ondernemingsniveau.

Tools en Middelen

Moderne vertaaltesting maakt vaak gebruik van platformen die meerdere evaluatiemethoden samenbrengen. Eén voorbeeld is DubSmart, dat een breed scala aan testmogelijkheden en geavanceerde inhoudverificatiesystemen biedt.

Belangrijke componenten van effectieve testen zijn onder meer:

- COMET-gebaseerde kwaliteitspoorten met drempelwaarden onder 0.6

- Glossaria die zijn beoordeeld op culturele relevantie

- Telersystemen die om de twee weken worden bijgewerkt

Voor gespecialiseerde gebieden zoals medische, juridische en technische inhoud, combineert het testen algemene metriek met branche-specifieke. Deze benadering heeft geleid tot een verbetering van 22% in kwaliteit bij gebruik van gecombineerde evaluatiesystemen.

Veelgestelde Vragen

Wat zijn de nadelen van de BLEU-score?

De BLEU-score, hoewel veelvuldig gebruikt, heeft aanzienlijke beperkingen bij toepassing op de kwaliteitsbeoordeling van vertalingen. Hier zijn de voornaamste zwakke punten:

| Beperking | Effect op Vertaalbeoordeling |

|---|---|

| Semantische Blindheid | Richt zich alleen op woordovereenkomsten, negeert betekenis of context |

| Straf op Uitdrukkingsvariatie | Bestraft geldige vertalingen die andere uitdrukkingen gebruiken dan referentieteksten |

Om deze kwesties aan te pakken, gebruiken veel video-localisatieplatformen een mix van evaluatiemethoden. Bijvoorbeeld, DubSmart's contextanalyzer combineert meerdere metriek om een nauwkeuriger beoordeling te bieden.

"Hoewel BLEU basismetingen biedt, vergt uitgebreid testen semantische en contextuele analyse - vooral voor bedrijfskritische vertalingen."

Voor betere nauwkeurigheid raden experts aan:

- COMET voor het evalueren van betekenis en semantiek

- Menselijke validatie voor het begrijpen van culturele nuances

- Taal specifieke tools voor het hanteren van complexe grammaticastrukturen

Deze gelaagde benadering, zoals gebruikt door DubSmart, combineert geautomatiseerde tools met menselijke inzichten om ervoor te zorgen dat vertalingen zowel aan technische als contextuele normen voldoen.